Tối ngày 18 tháng 11 năm 2025, một sự kiện chưa từng có trong nhiều năm trở lại đây đã xảy ra với mạng lưới internet toàn cầu. Từ khoảng 18 giờ 20 phút theo giờ Việt Nam (tức 11 giờ 20 phút UTC), hàng triệu người dùng khắp thế giới bất ngờ không thể truy cập vào các dịch vụ quen thuộc như ChatGPT, mạng xã hội X (Twitter), Canva, Discord, League of Legends và hàng loạt website khác.

Nguyên nhân không phải từ một cuộc tấn công mạng hay sự cố kết nối internet, mà đến từ Cloudflare – một trong những trụ cột quan trọng nhất của cơ sở hạ tầng internet hiện đại. Sự cố này đã khiến khoảng 20% tổng số website trên toàn thế giới tạm thời ngừng hoạt động, ảnh hưởng đến hàng tỷ người dùng và các doanh nghiệp lớn nhỏ.

Đây được đánh giá là sự cố nghiêm trọng nhất của Cloudflare kể từ năm 2019, một lời nhắc nhở đanh thép về sự mong manh của internet hiện đại khi quá phụ thuộc vào một số ít nhà cung cấp dịch vụ hạ tầng.

Cloudflare là gì và tại sao nó lại quan trọng đến vậy?

Trong thế giới internet hiện đại, Cloudflare đóng vai trò như một người gác cổng im lặng nhưng vô cùng quan trọng. Mỗi ngày, hàng tỷ yêu cầu truy cập website trên toàn cầu đều phải đi qua hệ thống của Cloudflare trước khi đến được đích cuối cùng. Nền tảng này không chỉ đơn thuần là một nhà cung cấp dịch vụ mạng, mà là cột trụ nâng đỡ cho khoảng một phần năm của toàn bộ internet.

Từ các trang tin tức lớn, nền tảng thương mại điện tử, cho đến những blog cá nhân nhỏ – tất cả đều tin tưởng giao phó sự an toàn và hiệu suất của mình cho Cloudflare. Nhưng điều gì khiến công ty này trở nên không thể thiếu đến vậy? Câu trả lời nằm ở vai trò đa nhiệm mà nó đảm nhận: từ việc tăng tốc độ tải trang, bảo vệ khỏi các cuộc tấn công mạng, cho đến quản lý hệ thống tên miền. Khi Cloudflare hoạt động tốt, không ai chú ý đến sự hiện diện của nó. Nhưng khi nó gặp sự cố, cả thế giới đều cảm nhận được.

Người gác cổng của internet hiện đại

Cloudflare là một công ty hạ tầng internet và bảo mật có trụ sở tại San Francisco, Hoa Kỳ, được thành lập vào năm 2009. Nhiều người dùng internet thường ngày có thể chưa từng nghe đến cái tên này, nhưng thực tế họ đang tương tác với dịch vụ của Cloudflare mỗi khi truy cập website.

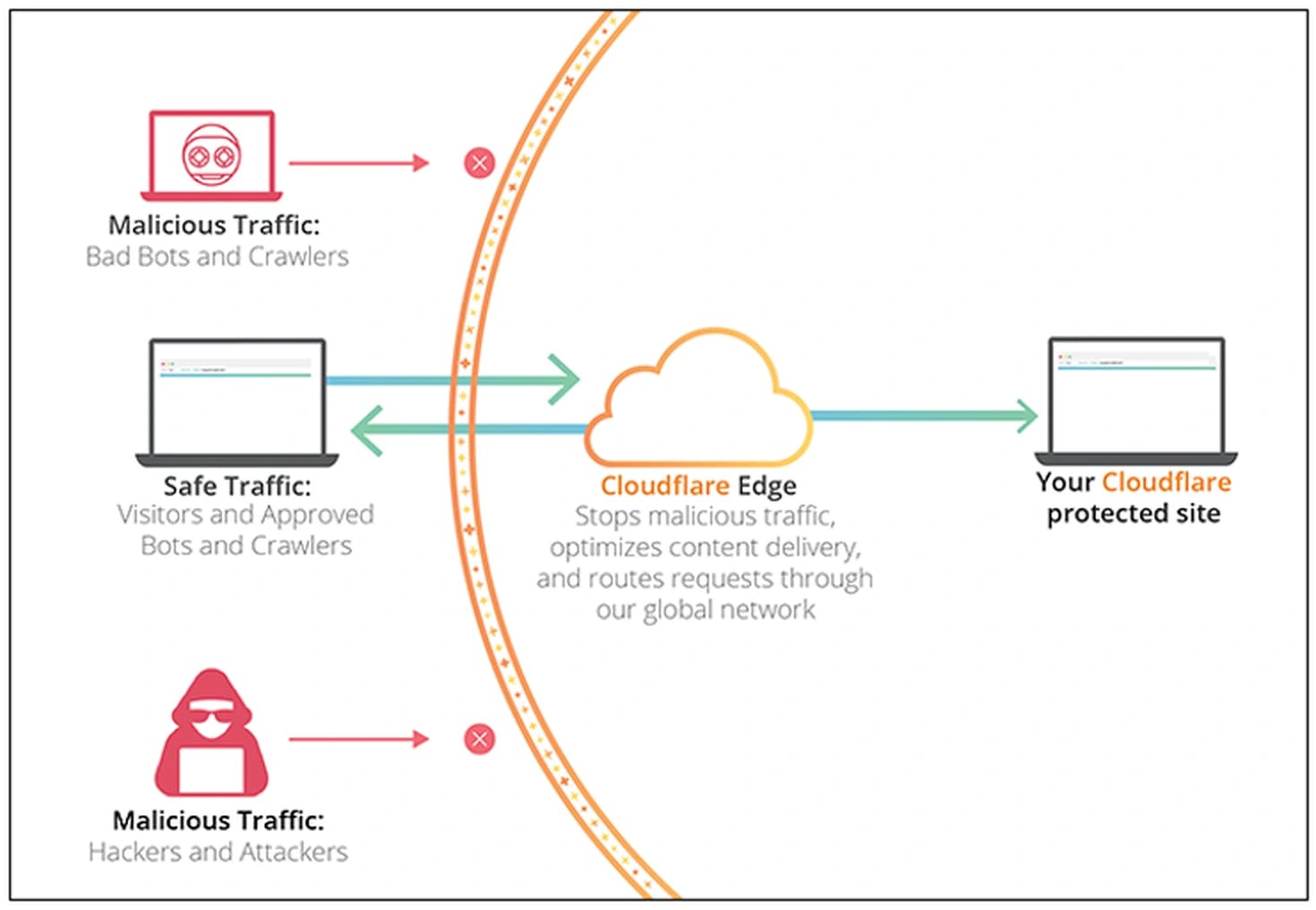

Công ty này cung cấp mạng lưới phân phối nội dung (Content Delivery Network – CDN), dịch vụ bảo mật website, hệ thống chống tấn công từ chối dịch vụ phân tán (DDoS), quản lý tên miền DNS, và nhiều dịch vụ quan trọng khác cho hàng triệu website trên toàn cầu. Cloudflare tự mô tả mình là hệ miễn dịch cho internet, đóng vai trò như một lớp bảo vệ và tối ưu hóa nằm giữa người dùng cuối và máy chủ gốc của các website.

Khi một website sử dụng dịch vụ của Cloudflare, mọi yêu cầu truy cập từ người dùng sẽ không đi thẳng đến máy chủ gốc, mà phải đi qua mạng lưới gồm hàng nghìn trung tâm dữ liệu của Cloudflare trải rộng khắp thế giới. Tại đây, Cloudflare thực hiện nhiều nhiệm vụ quan trọng như lọc bỏ các truy cập độc hại, chặn các cuộc tấn công mạng, lưu bộ nhớ đệm nội dung để tăng tốc độ tải trang, và phân phối nội dung từ máy chủ gần nhất với người dùng.

Điều này không chỉ giúp website hoạt động nhanh hơn mà còn bảo vệ chúng khỏi các mối đe dọa từ tin tặc. Theo ước tính, hiện có khoảng 20% tổng số website trên toàn cầu đang sử dụng dịch vụ của Cloudflare, bao gồm cả những tên tuổi lớn như Discord, Shopify, các trang báo điện tử hàng đầu, và vô số dịch vụ trực tuyến khác. Chính vì vai trò trung tâm này mà khi Cloudflare gặp sự cố, hậu quả lan rộng với tốc độ chóng mặt.

Từ lá chắn bảo vệ thành rào cản vô tình

Trong hoạt động bình thường, Cloudflare hoạt động như một tấm lá chắn vững chắc bảo vệ các website khỏi vô số mối đe dọa hàng ngày. Công ty này xử lý hàng nghìn tỷ yêu cầu mỗi ngày, chặn đứng hàng triệu cuộc tấn công DDoS, lọc ra bot độc hại, và giúp các website duy trì hoạt động ổn định ngay cả khi đối mặt với lưu lượng truy cập khổng lồ.

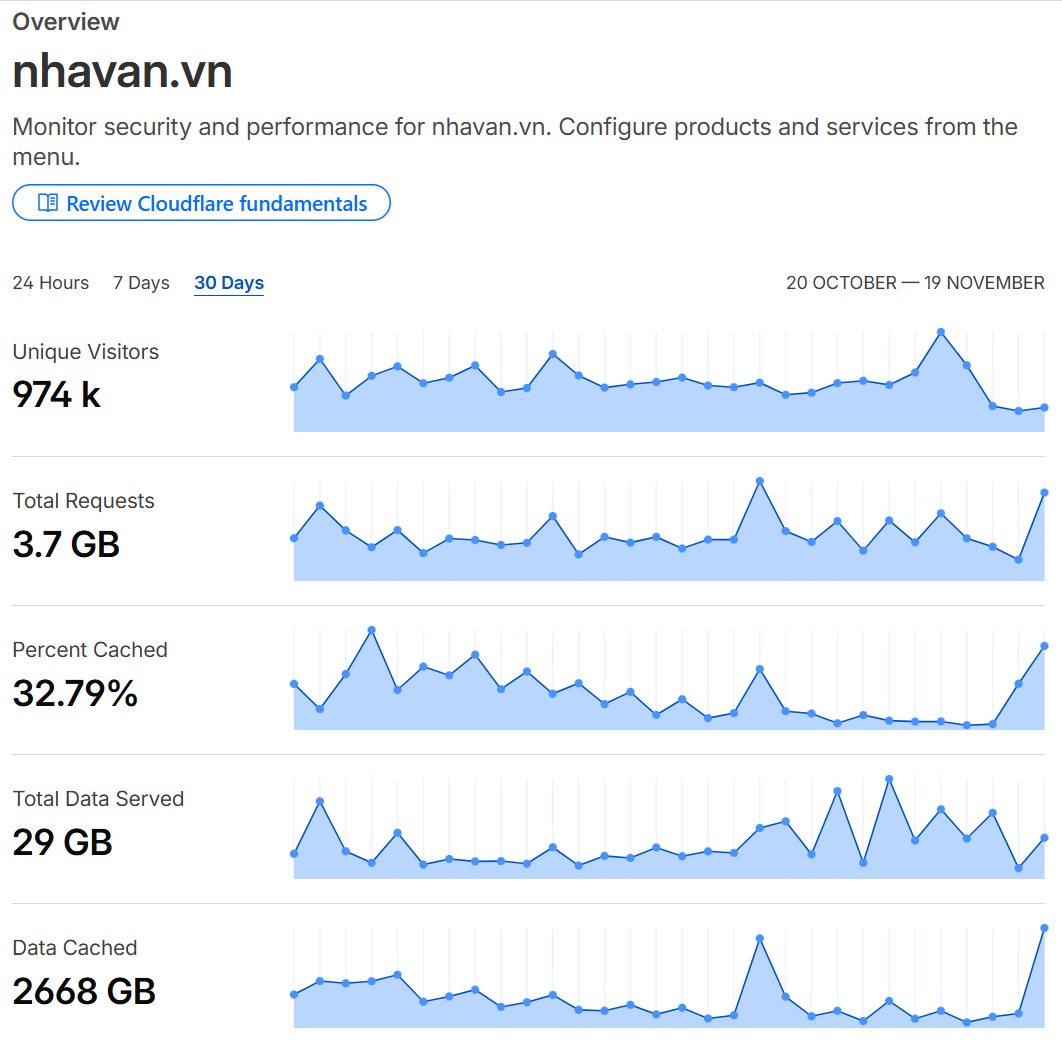

Đây là lý do tại sao nhiều website và dịch vụ trực tuyến, từ những blog cá nhân nhỏ như Nhavanvn cho đến các nền tảng công nghệ hàng tỷ đô, đều tin tưởng giao phó hạ tầng mạng của mình cho Cloudflare. Tuy nhiên, chính sự phụ thuộc lớn này cũng tạo nên một điểm yếu chí mạng – khi Cloudflare gặp trục trặc, tấm lá chắn đó bất ngờ biến thành rào cản khiến người dùng không thể tiếp cận website.

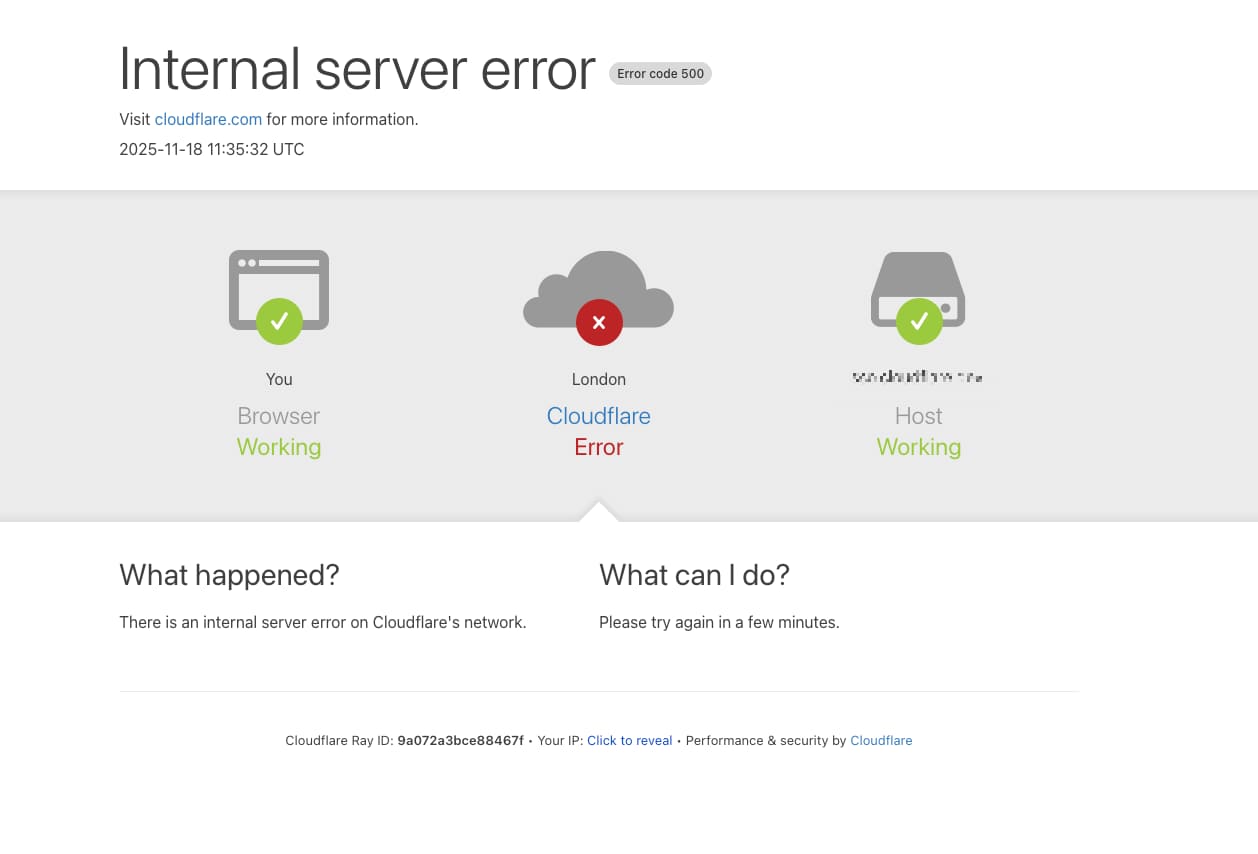

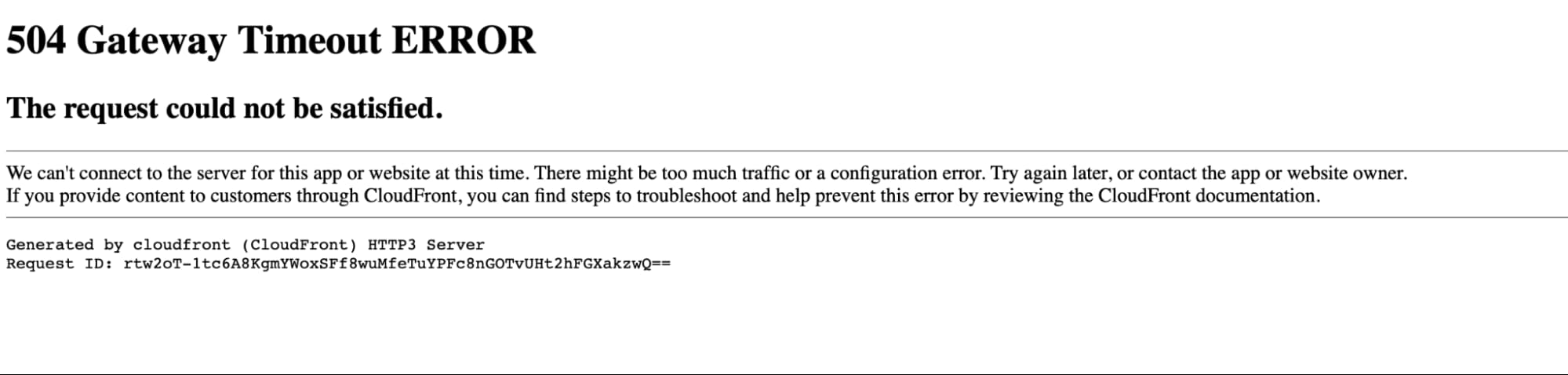

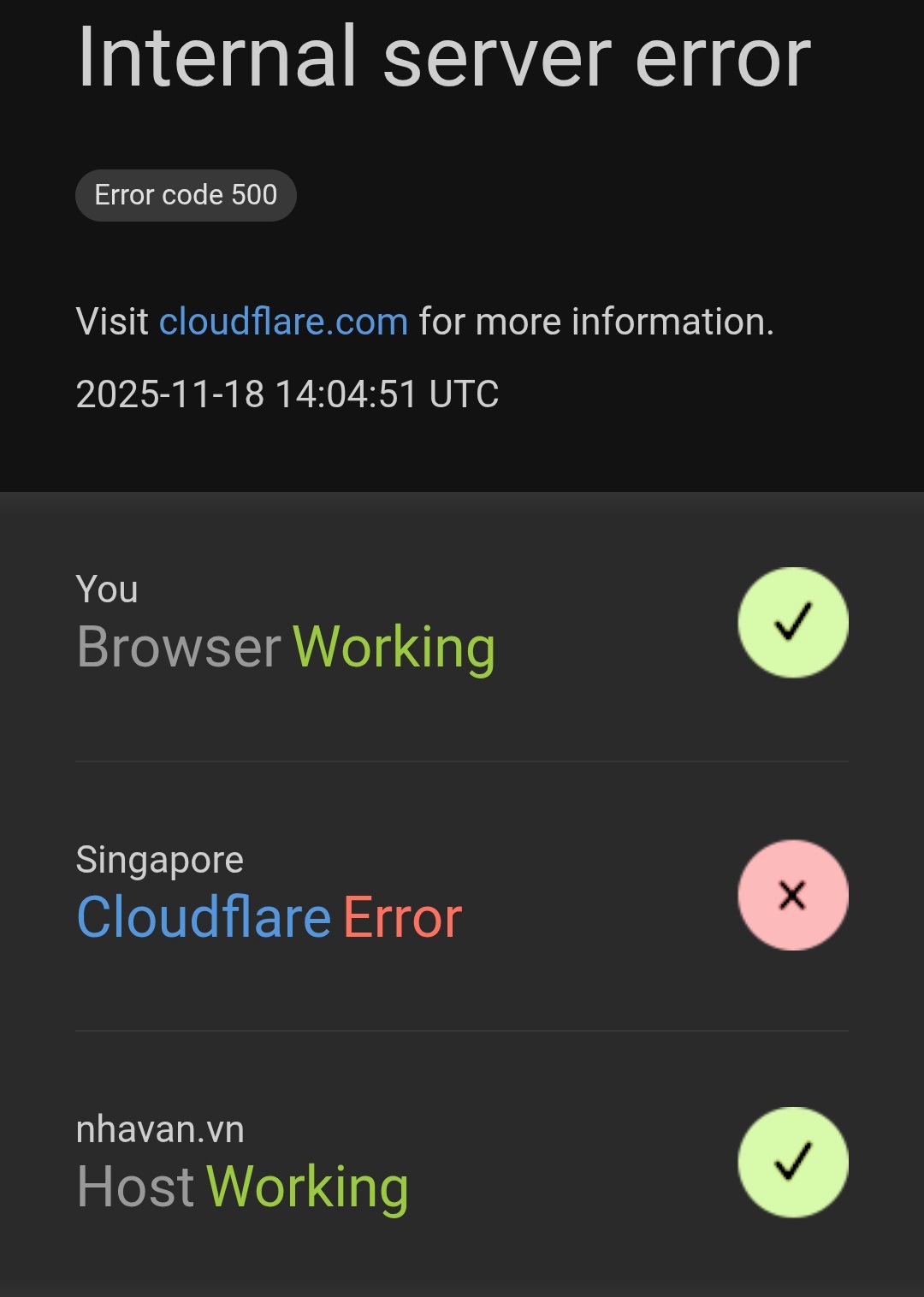

Điều xảy ra vào tối 18 tháng 11 năm 2025 là một minh chứng điển hình cho điều này. Khi hệ thống của Cloudflare gặp lỗi nghiêm trọng, tất cả các website đang nằm sau lớp bảo vệ của Cloudflare đều bị ảnh hưởng. Người dùng cố gắng truy cập các website yêu thích của họ chỉ nhận được thông báo lỗi với dòng chữ Cloudflare Error hoặc Vui lòng bỏ chặn challenges.cloudflare.com để tiếp tục.

Nhiều người trong số họ nghĩ rằng vấn đề nằm ở thiết bị hay kết nối internet của mình, nên đã khởi động lại máy tính, điện thoại, thậm chí cả modem wifi, nhưng tất nhiên không có gì thay đổi.

Thực tế cho thấy dù kết nối internet của họ vẫn hoàn toàn bình thường, nhưng họ không thể truy cập được các website vì cánh cổng Cloudflare đang đóng chặt.

Sự cố này một lần nữa đặt ra câu hỏi về sự tập trung hóa quá mức trong hạ tầng internet hiện đại, khi quá nhiều dịch vụ quan trọng phụ thuộc vào một số ít nhà cung cấp.

Quy mô ảnh hưởng đáng kinh ngạc

Con số 20% website toàn cầu không chỉ là một thống kê khô khan, mà đại diện cho hàng triệu website đa dạng phục vụ mọi nhu cầu của con người.

Từ các công cụ AI như ChatGPT và Claude AI mà hàng triệu người dùng hàng ngày, đến các nền tảng mạng xã hội như X (Twitter) và Discord nơi mọi người kết nối và giao tiếp, từ các công cụ thiết kế như Canva phục vụ công việc và sáng tạo, cho đến các trò chơi trực tuyến như League of Legends và Fortnite mang lại giải trí cho hàng chục triệu game thủ – tất cả đều bị ảnh hưởng đồng loạt.

Thậm chí cả DownDetector, website chuyên theo dõi tình trạng hoạt động của các dịch vụ internet khác, cũng không thể truy cập được vì nó cũng đang dùng dịch vụ của Cloudflare.

Tại Việt Nam, tác động cũng không nhỏ hơn. Nhiều trang báo điện tử lớn, các nền tảng thương mại điện tử, dịch vụ tài chính trực tuyến và vô số website khác đều hiển thị trang lỗi.

Anh Mạnh Sơn từ Hà Nội kể lại: Đang làm việc trên Canva thì bị lỗi, mở ChatGPT để xử lý tiếp cũng không được. Hàng nghìn người dùng Việt Nam và trên toàn thế giới đã phản ánh tình trạng tương tự trên các diễn đàn và mạng xã hội còn hoạt động được.

Điều đáng chú ý là một số dịch vụ vẫn hoạt động được trên ứng dụng di động nhưng lại bị lỗi trên website, cho thấy sự cố không phải do kết nối internet của người dùng mà đến từ hạ tầng phía máy chủ.

Quy mô ảnh hưởng này không chỉ gây bất tiện cho người dùng cá nhân mà còn tác động nghiêm trọng đến hoạt động kinh doanh của vô số công ty, gián đoạn các giao dịch thương mại điện tử, làm gián đoạn công việc của hàng triệu người, và thậm chí ảnh hưởng đến các dịch vụ quan trọng khác.

Giải phẫu sự cố – Khi một thay đổi nhỏ gây ra hậu quả khổng lồ

Trong thế giới công nghệ, có một nguyên tắc bất thành văn: những thảm họa lớn nhất thường bắt nguồn từ những thay đổi tưởng chừng như vô hại nhất. Sự cố Cloudflare ngày 18 tháng 11 là một minh chứng hoàn hảo cho điều này.

Không phải do một cuộc tấn công mạng tinh vi hay một lỗi phần cứng nghiêm trọng, mà chỉ đơn giản là một thay đổi nhỏ trong cấu hình phân quyền cơ sở dữ liệu đã tạo ra hiệu ứng domino khủng khiếp.

Một truy vấn SQL thông thường, được chạy định kỳ mỗi 5 phút để tạo tệp cấu hình, bất ngờ bắt đầu trả về dữ liệu trùng lặp. Tệp cấu hình phình to gấp 3 lần, vượt qua giới hạn an toàn của hệ thống. Và từ đó, hàng nghìn máy chủ trên khắp thế giới đồng loạt sụp đổ như những quân domino ngã theo chuỗi.

Câu chuyện về cách một thay đổi 15 phút trong cơ sở dữ liệu có thể khiến 20% internet toàn cầu ngừng hoạt động là một bài học đắt giá về sự phức tạp và mong manh của hạ tầng công nghệ hiện đại.

Nguồn gốc của thảm họa

Trái với những gì nhiều người lo ngại ban đầu, sự cố ngày 18 tháng 11 không phải do một cuộc tấn công mạng hay hoạt động phá hoại từ tin tặc. Nguyên nhân thực sự đơn giản và đáng sợ hơn nhiều – một thay đổi về phân quyền trong hệ thống cơ sở dữ liệu nội bộ của Cloudflare.

Cụ thể, vào lúc 11 giờ 05 phút UTC, đội ngũ kỹ thuật của Cloudflare đã triển khai một thay đổi trong cấu hình phân quyền truy cập của cụm cơ sở dữ liệu ClickHouse – hệ thống được sử dụng để quản lý và truy vấn dữ liệu phục vụ cho nhiều dịch vụ khác nhau. Mục đích ban đầu của thay đổi này hoàn toàn chính đáng: cải thiện tính bảo mật và độ tin cậy của các truy vấn phân tán bằng cách cho phép người dùng xem được metadata của các bảng dữ liệu họ có quyền truy cập.

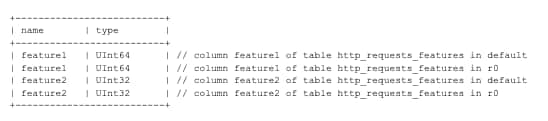

Trước đó, khi các kỹ sư truy vấn thông tin về cấu trúc bảng dữ liệu thông qua các lệnh như SELECT name, type FROM system.columns WHERE table = 'http_requests_features' thì hệ thống chỉ trả về thông tin về các bảng trong cơ sở dữ liệu default sẵn có. Tuy nhiên, sau khi áp dụng thay đổi về phân quyền, truy vấn tương tự bắt đầu trả về cả thông tin của các bảng nằm trong cơ sở dữ liệu r0 – nơi dữ liệu thực sự được lưu trữ trên từng phân đoạn (shard) của cụm ClickHouse.

SELECT

name,

type

FROM system.columns

WHERE

table = 'http_requests_features'

order by name;Điều này có nghĩa là mỗi cột dữ liệu giờ đây xuất hiện hai lần trong kết quả truy vấn: một lần từ bảng phân tán trong default và bảng cơ sở trong r0 thêm lần nữa. Vấn đề nằm ở chỗ truy vấn này không có bộ lọc để chỉ lấy dữ liệu từ một cơ sở dữ liệu cụ thể, dẫn đến việc kết quả bị nhân đôi một cách không mong muốn.

Hiệu ứng domino từ tệp cấu hình

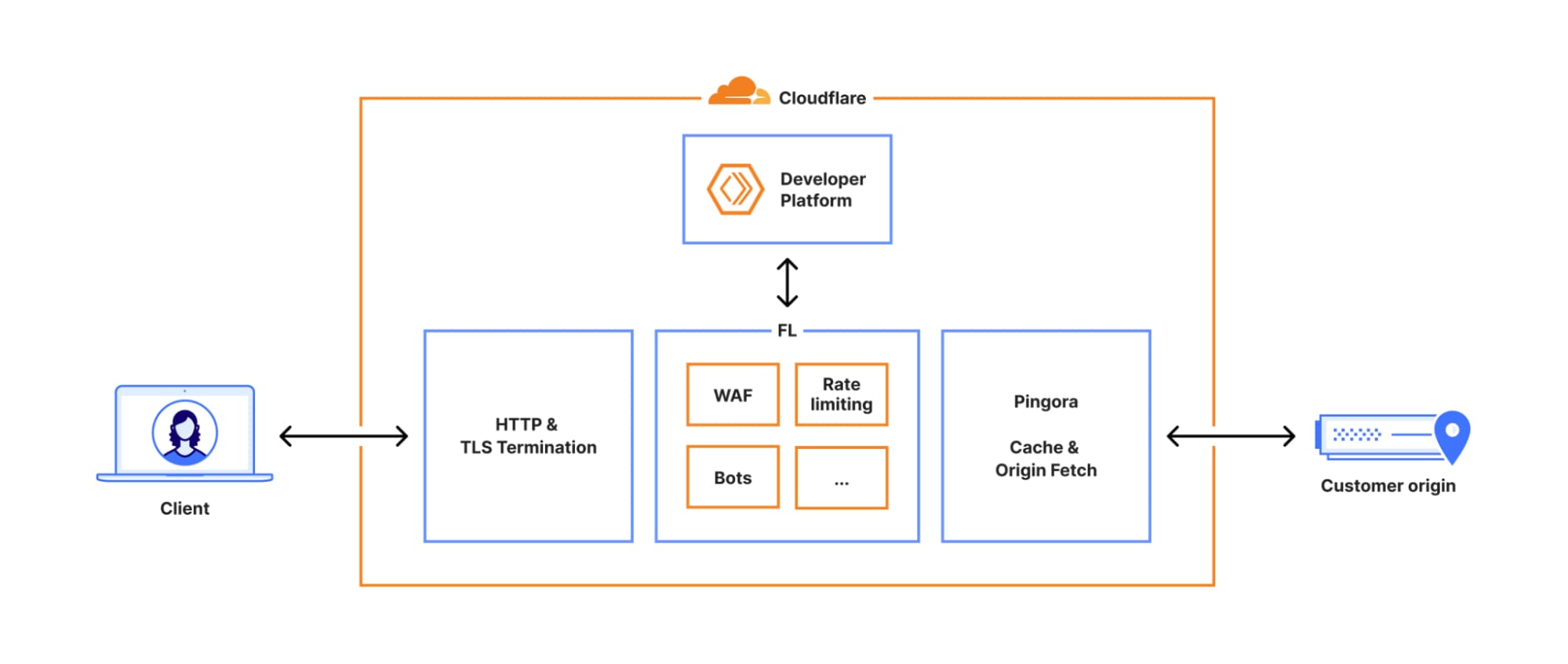

Truy vấn có vấn đề này không phải được chạy một lần mà được thực thi định kỳ mỗi 5 phút để tạo ra một tệp cấu hình tính năng (feature file) phục vụ cho hệ thống quản lý bot (Bot Management) của Cloudflare. Hệ thống Bot Management này đóng vai trò cực kỳ quan trọng trong việc bảo vệ các website khỏi lưu lượng truy cập tự động độc hại, sử dụng mô hình học máy để phân tích từng yêu cầu đến máy chủ và gán cho nó một điểm bot (bot score) để xác định liệu đó có phải là truy cập từ người dùng thật hay từ bot tự động.

Tệp cấu hình tính năng chứa danh sách các đặc trưng (features) mà mô hình học máy sử dụng để đưa ra dự đoán – mỗi đặc trưng là một thuộc tính cá nhân được phân tích như địa chỉ IP, header của trình duyệt, hành vi nhấp chuột, và hàng chục yếu tố khác.

Trước sự cố, tệp này có kích thước cố định với khoảng 60 đặc trưng, một con số được tối ưu cẩn thận qua nhiều năm vận hành. Tuy nhiên, sau khi thay đổi phân quyền được triển khai, truy vấn bắt đầu trả về dữ liệu trùng lặp, khiến tệp cấu hình bất ngờ phình to lên gấp 3 với hơn 200 đặc trưng. Tệp phình to này sau đó được hệ thống tự động phân phối đến toàn bộ các máy chủ trên mạng lưới toàn cầu của Cloudflare mỗi 5 phút. Đây chính là khởi đầu của thảm họa.

Phần mềm xử lý lưu lượng mạng chạy trên hàng nghìn máy chủ này có một giới hạn cứng về số lượng đặc trưng tối đa nó có thể xử lý – con số đó là 200, được thiết lập vì lý do tối ưu hiệu suất và phân bổ bộ nhớ trước (memory preallocation). Khi tệp cấu hình với hơn 200 đặc trưng được nạp vào, hệ thống lập tức gặp lỗi nghiêm trọng.

Khi hệ thống đổ sập theo cách không ai ngờ tới

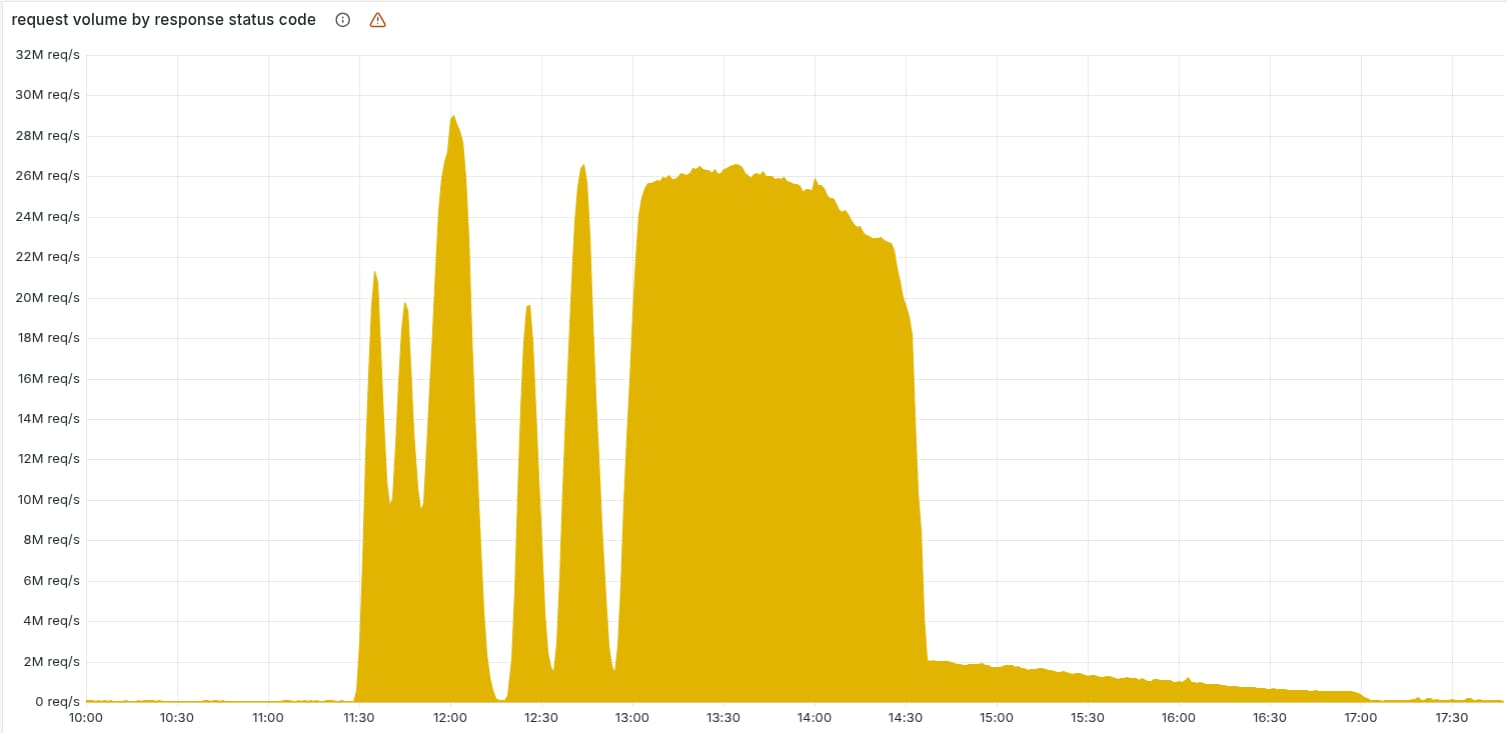

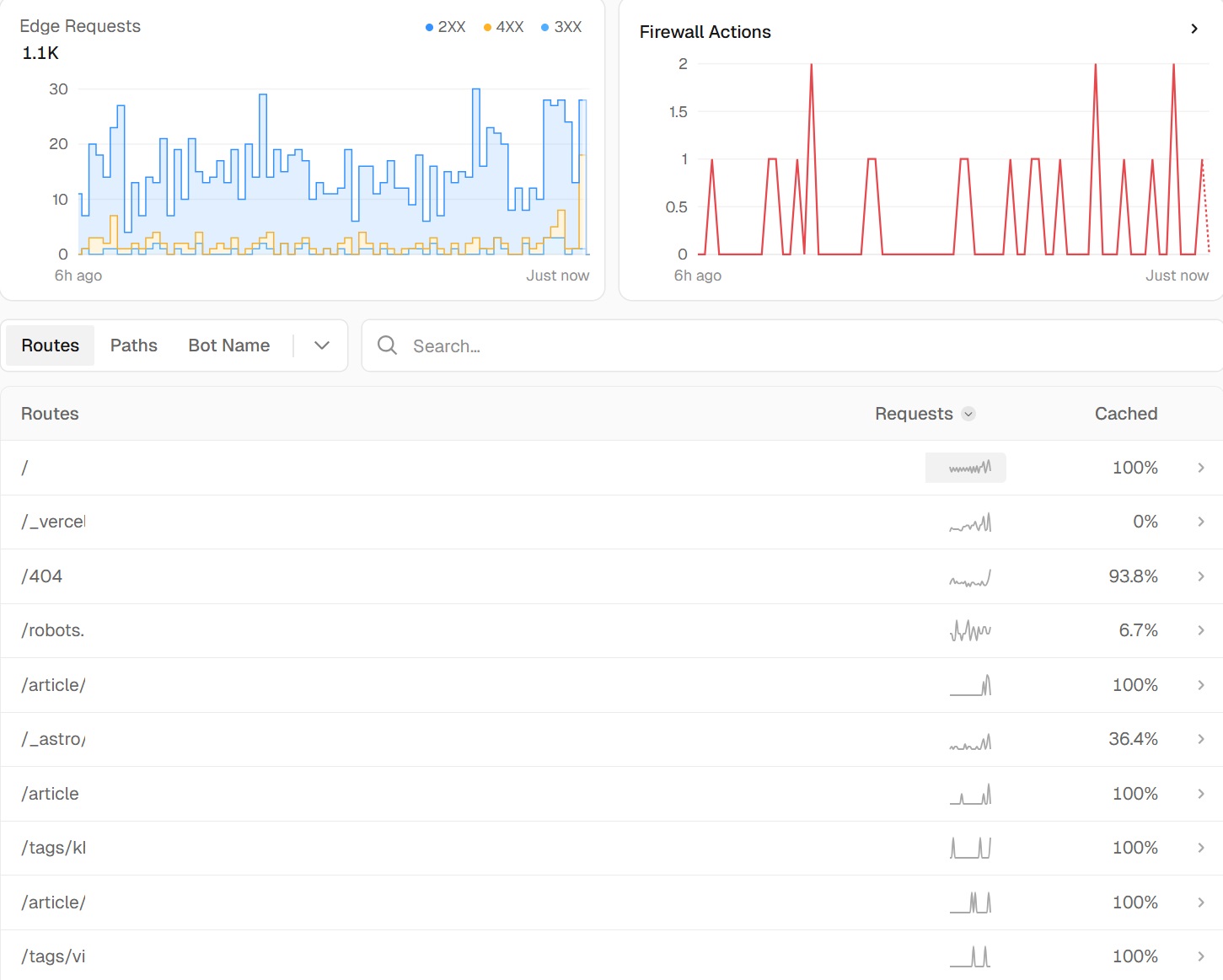

Điều làm tình hình trở nên phức tạp và khó chẩn đoán hơn là cách sự cố biểu hiện. Thay vì toàn bộ hệ thống sụp đổ cùng một lúc và ở trạng thái lỗi liên tục, các kỹ sư Cloudflare chứng kiến một hiện tượng kỳ lạ: hệ thống lúc hoạt động bình thường, lúc lại trả về mã lỗi HTTP 5xx hàng loạt, rồi lại tự phục hồi, rồi lại sập – theo một chu kỳ dao động khó hiểu.

Biểu đồ giám sát cho thấy số lượng lỗi tăng đột biến rồi giảm xuống, rồi lại tăng lên, tạo ra những đỉnh nhọn (spikes) liên tiếp trên đồ thị. Hành vi này hoàn toàn bất thường đối với một lỗi nội bộ thông thường, và ban đầu khiến nhóm phản ứng sự cố nghi ngờ đây có thể là một cuộc tấn công DDoS quy mô cực lớn, đặc biệt là khi họ nhận ra trang giám sát trạng thái hệ thống (status page) của Cloudflare – được lưu trữ hoàn toàn độc lập ngoài hạ tầng Cloudflare – cũng không truy cập được (mặc dù sau này xác định đây chỉ là một sự trùng hợp đáng tiếc).

Giải thích cho hiện tượng dao động này nằm ở cách hệ thống cơ sở dữ liệu ClickHouse hoạt động. Cụm ClickHouse của Cloudflare được cấu hình thành nhiều phân đoạn (shards), và việc thay đổi phân quyền được triển khai dần dần trên từng phân đoạn, không phải tất cả cùng một lúc.

Mỗi 5 phút, khi truy vấn tạo tệp cấu hình được chạy, nó có thể rơi vào một phân đoạn đã được cập nhật (sẽ tạo ra tệp xấu với dữ liệu trùng lặp) hoặc một phân đoạn chưa được cập nhật (sẽ tạo ra tệp tốt với dữ liệu đúng). Hệ thống phân phối tệp sau đó nhanh chóng đẩy tệp mới nhất – dù tốt hay xấu – đến toàn bộ mạng lưới. Khi tệp tốt được phân phối, các máy chủ hoạt động bình thường.

Nhưng 5 phút sau, nếu một tệp xấu được tạo ra và phân phối, toàn bộ hệ thống lại sụp đổ. Chu kỳ này tiếp diễn cho đến khi cuối cùng tất cả các phân đoạn ClickHouse đều được cập nhật, và từ đó chỉ có tệp xấu được tạo ra, khiến sự cố ổn định ở trạng thái lỗi liên tục.

Diễn biến sự cố và nỗ lực khắc phục

3 giờ đồng hồ căng thẳng, từ 18 giờ 28 phút đến gần 23 giờ tối theo giờ Việt Nam, đội ngũ kỹ sư Cloudflare đã trải qua một trong những thử thách khó khăn nhất trong sự nghiệp của họ. Đây không chỉ là cuộc đua với thời gian để khôi phục dịch vụ, mà còn là bài kiểm tra về khả năng chẩn đoán và xử lý khủng hoảng dưới áp lực cực lớn.

Từ những phút đầu tiên khi hệ thống cảnh báo bắt đầu kêu inh ỏi, cho đến khi cuối cùng tất cả dịch vụ được khôi phục hoàn toàn, đội ngũ phản ứng sự cố đã phải đối mặt với một loạt các thách thức chồng chất. Các triệu chứng ban đầu gây nhầm lẫn, khiến họ nghi ngờ đây là một cuộc tấn công DDoS quy mô lớn.

Hành vi dao động kỳ lạ của hệ thống – lúc hoạt động bình thường, lúc lại sập hoàn toàn – làm việc chẩn đoán trở nên phức tạp gấp bội. Và ngay cả khi đã xác định được nguyên nhân, việc triển khai giải pháp cũng không hề đơn giản khi phải đối mặt với một hệ thống phân tán toàn cầu với hàng nghìn máy chủ.

3 giờ đối mặt với khủng hoảng

11 giờ 28 phút UTC (18 giờ 28 phút theo giờ Việt Nam), khi triển khai thay đổi cơ sở dữ liệu đến môi trường khách hàng và các lỗi đầu tiên được phát hiện, đội ngũ kỹ thuật của Cloudflare bước vào một cuộc chiến cam go với thời gian.

11 giờ 31 phút, sau khi hệ thống kiểm tra tự động đầu tiên phát hiện vấn đề, cuộc điều tra thủ công bắt đầu ngay 1 phút kế tiếp.

11 giờ 35 phút, cuộc họp phản ứng sự cố khẩn cấp được triệu tập, tập hợp các kỹ sư cao cấp nhất từ nhiều phòng ban khác nhau.

Từ 11 giờ 32 đến 13 giờ 05 phút, cả đội đã tập trung điều tra các triệu chứng ban đầu – tỷ lệ phản hồi của Workers KV (một dịch vụ lưu trữ key value phổ biến của Cloudflare) giảm sút nghiêm trọng, gây ra tác động lan tỏa đến nhiều dịch vụ khác phụ thuộc vào nó. Các biện pháp giảm thiểu ban đầu bao gồm điều chỉnh lưu lượng, giới hạn tài khoản, và thử nghiệm nhiều cách khác nhau để đưa Workers KV trở lại hoạt động bình thường, nhưng tất cả đều không mang lại hiệu quả như mong đợi.

13 giờ 05 phút, bước đột phá đầu tiên xuất hiện, khi đội ngũ quyết định cho Workers KV và Cloudflare Access (dịch vụ xác thực truy cập) vượt qua (bypass) hệ thống proxy chính và quay về sử dụng phiên bản cũ hơn của proxy.

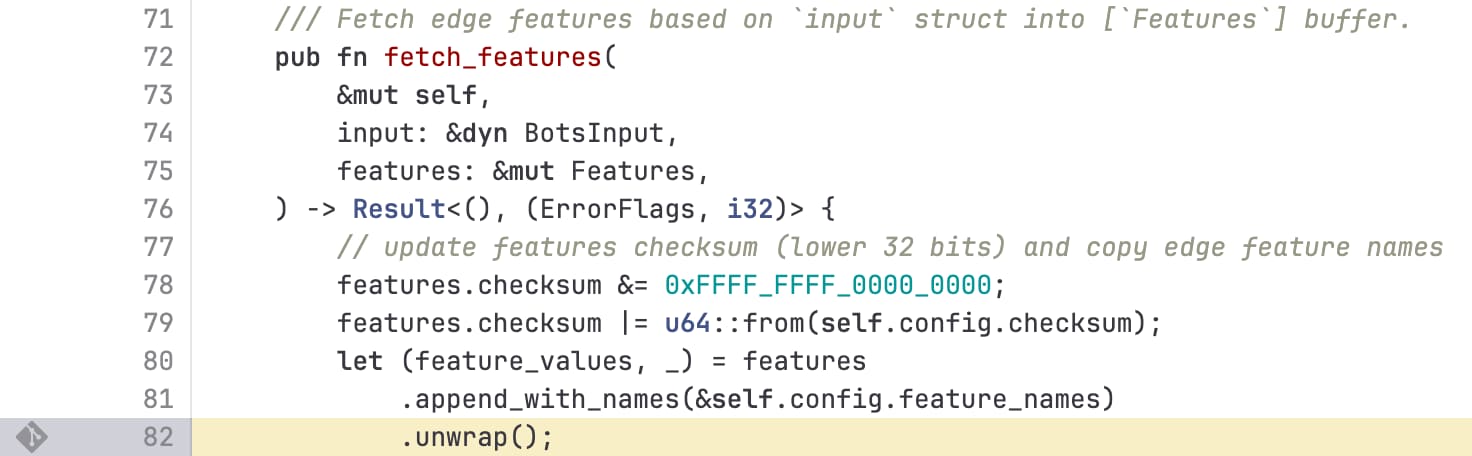

Mặc dù vấn đề cũng tồn tại ở phiên bản cũ, nhưng tác động nhỏ hơn nhiều do cách xử lý lỗi khác nhau. Ở proxy mới (FL2) được viết bằng ngôn ngữ Rust, khi gặp giới hạn 200 đặc trưng, chương trình gọi hàm unwrap() trên một kết quả lỗi, gây ra panic (sự cố nghiêm trọng khiến luồng xử lý dừng đột ngột) và trả về lỗi HTTP 5xx cho người dùng. Trong khi đó, ở proxy cũ (FL), cùng một vấn đề chỉ khiến điểm bot không được tạo đúng và tất cả lưu lượng nhận điểm bot bằng 0, vẫn cho phép lưu lượng đi qua.

Cuộc truy tìm thủ phạm thực sự

Từ 13 giờ 05 đến 14 giờ 30 phút là giai đoạn then chốt khi đội ngũ dần thu hẹp phạm vi và xác định chính xác nguyên nhân gốc rễ. Qua việc phân tích log hệ thống, theo dõi dữ liệu giám sát, và thực hiện nhiều thử nghiệm, các kỹ sư cuối cùng xác định được tệp cấu hình của Bot Management chính là thủ phạm gây ra toàn bộ sự cố. Họ tập trung nỗ lực vào nhiều hướng xử lý song song: một nhóm làm việc để khôi phục tệp cấu hình về phiên bản đã biết là hoạt động tốt trước đó, một nhóm khác điều tra sâu vào mã nguồn để hiểu tại sao giới hạn 200 đặc trưng lại bị vượt qua, và nhóm thứ ba chuẩn bị các biện pháp dự phòng trong trường hợp phương án chính không thành công.

13 giờ 37 phút, đội ngũ đã tự tin rằng việc khôi phục tệp cấu hình Bot Management về phiên bản cũ sẽ giải quyết được vấn đề, và đây trở thành hướng xử lý nhanh nhất. Tuy nhiên, việc thực hiện điều này không đơn giản như chỉ cần sao chép tệp. Hệ thống tự động vẫn đang tiếp tục tạo và phân phối tệp xấu mỗi 5 phút, nên việc đầu tiên là phải dừng ngay quá trình này.

14 giờ 24 phút, đội ngũ đã dừng thành công việc tạo và phân phối tệp cấu hình Bot Management mới. Ngay sau đó, họ tiến hành thử nghiệm với tệp cấu hình cũ đã được xác nhận hoạt động tốt, và quan sát thấy hệ thống phục hồi thành công.

14 giờ 30 phút, tệp cấu hình đúng đã được triển khai toàn cầu, và phần lớn các dịch vụ bắt đầu hoạt động trở lại bình thường. Đồng thời, đội ngũ cũng buộc khởi động lại hệ thống proxy chính để đảm bảo tất cả các thành phần đều nạp tệp mới.

Tuy nhiên, đây chưa phải là hồi kết của câu chuyện.

Dọn dẹp chiến trường sau cơn bão

Mặc dù nguyên nhân chính đã được xử lý, nhưng hậu quả của sự cố kéo dài đến tận 17 giờ 06 phút UTC (gần nửa đêm theo giờ Việt Nam) mới được giải quyết hoàn toàn. Sau khi tệp cấu hình đúng được triển khai, một số dịch vụ phụ thuộc vào các thành phần khác đã bị ảnh hưởng bởi sự cố vẫn tiếp tục gặp lỗi. Đội ngũ phải thủ công khởi động lại từng dịch vụ để đưa chúng thoát khỏi trạng thái lỗi.

Đặc biệt, từ 14 giờ 40 đến 15 giờ 30 phút, Cloudflare Dashboard trải qua đợt sập thứ hai do khối lượng yêu cầu đăng nhập tồn đọng khổng lồ từ người dùng đã không thể truy cập trong 3 giờ trước đó. Khi hệ thống bắt đầu hoạt động trở lại, hàng chục nghìn người dùng đồng loạt cố gắng đăng nhập, kết hợp với các lần thử lại tự động, tạo ra một lượng tải vượt quá khả năng xử lý của hệ thống xác thực. Vấn đề này được giải quyết bằng cách tăng khả năng xử lý đồng thời của các dịch vụ control plane và dashboard.

Đến 15 giờ 30 phút, tình trạng truy cập vào dashboard đã ổn định trở lại.

Trong khoảng thời gian còn lại, từ 15 giờ 30 đến 17 giờ 06 phút, đội ngũ tiếp tục giám sát chặt chẽ, khởi động lại các dịch vụ còn sót lại trong trạng thái lỗi, và xác nhận từng hệ thống một đã trở về hoạt động bình thường.

Cuối cùng, lúc 17 giờ 06 phút, Cloudflare chính thức công bố tất cả dịch vụ đã được khôi phục hoàn toàn.

Cuộc chiến kéo dài gần 6 giờ đồng hồ căng thẳng đã kết thúc, nhưng bài học để lại thì còn đó trong rất lâu.

Những dịch vụ bị ảnh hưởng và mức độ tác động

Khi Cloudflare gặp sự cố, hậu quả không đơn thuần là một vài website bị lỗi. Đây là một cơn sóng thần kỹ thuật số lan tràn khắp internet, ảnh hưởng đến vô số dịch vụ khác nhau với các mức độ nghiêm trọng khác nhau.

Từ những dịch vụ cốt lõi như CDN và hệ thống bảo mật – trái tim của toàn bộ mạng lưới Cloudflare – cho đến các dịch vụ phụ thuộc như Workers KV, Cloudflare Access, và Dashboard, tất cả đều bị cuốn vào cơn lốc này. Mỗi dịch vụ lại có cách biểu hiện lỗi riêng, tạo ra một bức tranh phức tạp về tác động lan tỏa.

Người dùng cuối chỉ thấy những trang lỗi với mã số khô khan như Error 530 hay HTTP 5xx, nhưng phía sau đó là cả một chuỗi phức tạp các hệ thống phụ thuộc lẫn nhau đang sụp đổ theo hiệu ứng domino. Đáng chú ý là ngay cả các công cụ dùng để theo dõi tình trạng sự cố cũng bị ảnh hưởng, khiến cả người dùng lẫn kỹ sư đều mò mẫm trong bóng tối.

Dịch vụ CDN và bảo mật cốt lõi – Trái tim ngừng đập

Dịch vụ bị ảnh hưởng nặng nề nhất chính là hệ thống mạng phân phối nội dung (CDN) và các dịch vụ bảo mật cốt lõi mà Cloudflare cung cấp cho hàng triệu website trên toàn thế giới. Đây là những dịch vụ nền tảng nhất, chiếm phần lớn lý do tại sao các công ty chọn Cloudflare.

Trong suốt thời gian sự cố, người dùng cố gắng truy cập các website này chỉ nhận được mã lỗi HTTP 5xx – một dạng lỗi máy chủ cho biết vấn đề nằm ở phía dịch vụ, không phải do lỗi từ người dùng. Trang lỗi điển hình hiển thị với tiêu đề lớn Error 530 cùng thông báo Return code 530: Site is frozen due to a Cloudflare error, khiến người dùng cuối hoàn toàn bất lực vì không có gì họ có thể làm để sửa chữa.

Hàng triệu website từ những blog cá nhân nhỏ cho đến các nền tảng thương mại điện tử lớn đều hiển thị trang lỗi tương tự, tạo ra một cảnh tượng hiếm thấy trên internet.

Ngoài việc trả về lỗi, các website vẫn còn hoạt động được cũng ghi nhận mức độ trễ (latency) tăng cao bất thường trong việc phản hồi yêu cầu từ người dùng. Nguyên nhân là do CPU trên các máy chủ Cloudflare đang bị tiêu tốn hết năng lực bởi các hệ thống gỡ lỗi và quan sát tự động.

Khi một lỗi không được xử lý xảy ra, các hệ thống này tự động thu thập thông tin bổ sung để giúp kỹ sư chẩn đoán, bao gồm core dumps (bản sao bộ nhớ tại thời điểm lỗi) và các báo cáo chi tiết khác. Trong điều kiện bình thường, đây là tính năng rất hữu ích, nhưng khi hàng nghìn máy chủ đồng loạt gặp lỗi liên tục, khối lượng thông tin gỡ lỗi được tạo ra đã trở thành một gánh nặng khổng lồ, làm chậm thêm toàn bộ hệ thống.

Đây cũng là một bài học quan trọng về việc các cơ chế giám sát và gỡ lỗi có thể vô tình làm trầm trọng thêm sự cố nếu không được thiết kế cẩn thận.

Workers KV và Cloudflare Access – Chuỗi phụ thuộc sụp đổ

Workers KV, một dịch vụ lưu trữ dữ liệu dạng key value phân tán toàn cầu được nhiều nhà phát triển sử dụng để xây dựng ứng dụng serverless, cũng chịu ảnh hưởng nghiêm trọng. Vì Workers KV phụ thuộc vào hệ thống proxy chính để xử lý các yêu cầu đến cổng trước (front end gateway) của nó, khi proxy gặp sự cố, Workers KV cũng bắt đầu trả về mã lỗi HTTP 5xx với tỷ lệ cao bất thường.

Điều này không chỉ ảnh hưởng trực tiếp đến các ứng dụng đang sử dụng Workers KV, mà còn tạo ra hiệu ứng domino lan sang các dịch vụ khác của Cloudflare phụ thuộc vào Workers KV.

Cloudflare Access – dịch vụ xác thực và kiểm soát truy cập dựa trên zero trust – là một trong những nạn nhân của chuỗi phụ thuộc này. Từ khi sự cố bắt đầu lúc 11 giờ 28 phút cho đến khi biện pháp khắc phục tạm thời được triển khai lúc 13 giờ 05 phút, phần lớn người dùng không thể xác thực thành công để truy cập vào các ứng dụng được bảo vệ bởi Access.

Điều đáng nói là tất cả các lần thử đăng nhập thất bại đều dẫn đến trang lỗi, có nghĩa là không một người dùng nào trong số đó thực sự tiếp cận được ứng dụng đích trong khi hệ thống xác thực đang gặp sự cố – một tin tốt từ góc độ bảo mật. Các phiên đăng nhập đã tồn tại trước đó không bị ảnh hưởng và vẫn hoạt động bình thường, chỉ có những người dùng mới cần đăng nhập mới gặp vấn đề.

Ngoài ra, bất kỳ cập nhật cấu hình nào được thực hiện trong thời gian này đều bị thất bại hoàn toàn hoặc được truyền đi với tốc độ cực chậm. May mắn là sau khi sự cố được giải quyết, tất cả các cấu hình đều được phục hồi thành công.

Các lần đăng nhập thành công trong khoảng thời gian sự cố – mặc dù hiếm – vẫn được ghi log đầy đủ và chính xác, đảm bảo tính minh bạch và khả năng kiểm toán.

Dashboard, Turnstile và các dịch vụ phụ thuộc khác

Dashboard của Cloudflare – công cụ mà khách hàng sử dụng hàng ngày để cấu hình dịch vụ, xem thống kê, và quản lý tài khoản – cũng không tránh khỏi tác động.

Mặc dù phần lớn chức năng của dashboard vẫn hoạt động, nhưng đa số người dùng không thể đăng nhập được vì Cloudflare Turnstile – dịch vụ xác minh người dùng thân thiện hơn so với CAPTCHA truyền thống – đã bị sự cố làm cho không thể tải được trên trang đăng nhập.

Turnstile gặp hai đợt ngừng hoạt động rõ rệt: từ 11 giờ 30 đến 13 giờ 10 phút và từ 14 giờ 40 đến 15 giờ 30 phút. Đợt đầu tiên do tác động trực tiếp từ sự cố Workers KV và được khắc phục khi Workers KV vượt qua hệ thống proxy chính. Đợt thứ hai xảy ra sau khi khôi phục dữ liệu cấu hình tính năng, là hậu quả của lượng yêu cầu đăng nhập tồn đọng khổng lồ làm quá tải hệ thống xác thực như đã đề cập ở phần trước.

Cloudflare Email Security cũng chịu ảnh hưởng nhất định, mặc dù không nghiêm trọng bằng các dịch vụ khác. Quá trình xử lý và gửi email vẫn hoạt động bình thường, nhưng hệ thống tạm thời mất quyền truy cập vào một nguồn dữ liệu về danh tiếng địa chỉ IP (IP reputation), dẫn đến giảm độ chính xác trong phát hiện thư rác (spam) và một số cơ chế phát hiện dựa trên tuổi tên miền mới không kích hoạt được.

Tuy nhiên, không có tác động nghiêm trọng nào đến khách hàng được ghi nhận. Một số hành động tự động chuyển thư (Auto Move) cũng thất bại, nhưng tất cả các thư bị ảnh hưởng đã được xem xét và xử lý khắc phục sau đó. Chuỗi tác động phức tạp này cho thấy mức độ phụ thuộc lẫn nhau giữa các dịch vụ trong một hệ sinh thái lớn như Cloudflare, và việc một thành phần nhỏ gặp sự cố có thể tạo ra hiệu ứng lan tỏa rộng khắp.

Bài học xương máu và kế hoạch khắc phục

Sau khi cơn bão đi qua và hệ thống trở lại hoạt động bình thường, công việc thực sự mới bắt đầu – việc nhìn lại, phân tích và rút ra bài học từ thảm họa vừa xảy ra. Cloudflare không che giấu sai lầm của mình, mà công khai thừa nhận những điểm yếu trong thiết kế hệ thống và quy trình vận hành đã dẫn đến sự cố nghiêm trọng này.

Từ việc truy vấn cơ sở dữ liệu thiếu bộ lọc rõ ràng, cho đến cách xử lý lỗi không đủ uyển chuyển trong mã nguồn Rust, từ giả định ngầm định không được ghi chép đầy đủ, cho đến các hệ thống gỡ lỗi vô tình làm trầm trọng thêm vấn đề – tất cả đều được mổ xẻ và phân tích kỹ lưỡng. Nhưng quan trọng hơn việc tìm ra lỗi là việc đưa ra kế hoạch hành động cụ thể để đảm bảo lịch sử không lặp lại.

Cloudflare đã công bố một lộ trình khắc phục toàn diện, từ cứng hóa quy trình xử lý tệp cấu hình, triển khai các công tắc tắt khẩn cấp, cho đến rà soát lại toàn bộ các chế độ thất bại của hệ thống.

Những sai lầm đáng lẽ có thể tránh được

Nhìn lại toàn bộ chuỗi sự kiện, có thể thấy sự cố này bắt nguồn từ nhiều điểm yếu trong thiết kế và quy trình vận hành hệ thống.

Trước hết, truy vấn cơ sở dữ liệu tạo ra tệp cấu hình Bot Management không có bộ lọc rõ ràng để chỉ lấy dữ liệu từ một cơ sở dữ liệu cụ thể, dẫn đến việc nó trả về kết quả trùng lặp khi cấu trúc quyền truy cập thay đổi. Đây là một giả định ngầm định – rằng truy vấn chỉ sẽ thấy các bảng trong database default – đã tồn tại từ lâu và không được ghi chép rõ ràng. Khi giả định này bị phá vỡ bởi thay đổi về phân quyền, không ai nhận ra hậu quả cho đến khi đã quá muộn.

Thứ hai, giới hạn 200 đặc trưng trong hệ thống Bot Management được thiết lập cao hơn nhiều so với mức sử dụng thực tế khoảng 60 đặc trưng, tạo ra cảm giác an toàn giả. Tuy nhiên, khi dữ liệu nhân đôi đột ngột, giới hạn này bị vượt qua và cơ chế xử lý lỗi không đủ tốt để phục hồi một cách uyển chuyển.

Điều đặc biệt đáng chú ý là cách hệ thống phản ứng với lỗi ở hai phiên bản proxy khác nhau. Ở FL2, khi phát hiện số lượng đặc trưng vượt quá giới hạn, mã nguồn gọi hàm Result::unwrap() trên một giá trị lỗi, khiến chương trình panic và dừng đột ngột, trả về lỗi 5xx cho người dùng. Trong khi đó, FL chỉ xử lý tình huống tương tự nhẹ nhàng hơn bằng cách không tạo điểm bot đúng đắn nhưng vẫn cho phép lưu lượng đi qua.

Sự khác biệt này cho thấy việc viết mã nguồn cần cân nhắc kỹ về cách xử lý các tình huống ngoại lệ – đôi khi việc fail gracefully (thất bại một cách uyển chuyển) tốt hơn là dừng hẳn. Ngoài ra, các hệ thống gỡ lỗi tự động, vốn được thiết kế để giúp ích trong việc chẩn đoán sự cố, lại vô tình làm trầm trọng thêm vấn đề bằng cách tiêu tốn quá nhiều tài nguyên CPU để tạo báo cáo lỗi khi hàng nghìn máy chủ đồng loạt gặp sự cố. Đây là một bài học về việc các cơ chế giám sát và gỡ lỗi cũng cần có giới hạn và cơ chế tự bảo vệ.

Lộ trình cứng rắn để không lặp lại lịch sử

Cloudflare đã công bố một loạt biện pháp khắc phục toàn diện nhằm đảm bảo một sự cố tương tự sẽ không bao giờ xảy ra lần nữa.

Đầu tiên và quan trọng nhất là việc cứng hóa (hardening) quy trình xử lý các tệp cấu hình do chính Cloudflare tạo ra. Trước đây, các tệp này được tin cậy ngầm định vì chúng được tạo bởi hệ thống nội bộ, nhưng sự cố cho thấy giả định này nguy hiểm như thế nào. Từ nay, tất cả các tệp cấu hình, dù được tạo bởi ai, sẽ phải trải qua cùng một quy trình xác thực nghiêm ngặt như dữ liệu đầu vào từ người dùng bên ngoài. Điều này bao gồm kiểm tra kích thước, định dạng, giới hạn giá trị, và các điều kiện hợp lệ khác trước khi cho phép chúng được phân phối đến hệ thống sản xuất.

Thứ hai, Cloudflare đang triển khai nhiều công tắc tắt khẩn cấp toàn cầu (global kill switches) cho các tính năng quan trọng. Trong sự cố lần này, việc dừng tạo và phân phối tệp cấu hình Bot Management mất khá nhiều thời gian vì không có một cơ chế tắt nhanh đã được chuẩn bị sẵn. Các công tắc khẩn cấp mới sẽ cho phép đội ngũ vận hành tắt ngay lập tức một tính năng gặp vấn đề trên toàn bộ mạng lưới chỉ bằng một lệnh đơn giản, giảm thiểu thời gian từ phát hiện đến khắc phục.

Thứ ba, các hệ thống gỡ lỗi và báo cáo lỗi đang được thiết kế lại để loại bỏ khả năng chúng có thể làm quá tải tài nguyên hệ thống. Điều này bao gồm việc giới hạn số lượng báo cáo lỗi được tạo ra trong một khoảng thời gian, ưu tiên hóa việc thu thập thông tin quan trọng nhất, và đảm bảo các hoạt động gỡ lỗi không ảnh hưởng đến khả năng phục vụ người dùng.

Rà soát toàn diện các chế độ thất bại

Cuối cùng và có lẽ quan trọng nhất, Cloudflare đang tiến hành một cuộc rà soát toàn diện về các chế độ thất bại (failure modes) của tất cả các module trong hệ thống proxy chính. Mục tiêu là xác định và cải thiện cách mỗi module phản ứng khi gặp lỗi, đảm bảo rằng chúng có thể thất bại một cách uyển chuyển thay vì gây sụp đổ toàn bộ hệ thống.

Điều này bao gồm việc xem xét lại tất cả các trường hợp sử dụng hàm unwrap() và các cấu trúc xử lý lỗi tương tự trong mã nguồn Rust, thay thế chúng bằng các cơ chế xử lý lỗi an toàn hơn. Ngoài ra, Cloudflare cũng đang xem xét lại tất cả các giả định ngầm định trong mã nguồn và quy trình vận hành, ghi chép chúng một cách rõ ràng, và thêm các bài kiểm tra tự động để phát hiện khi các giả định này bị vi phạm.

Các kỹ sư cũng đang làm việc để cải thiện khả năng quan sát (observability) của hệ thống, đảm bảo rằng các vấn đề tương tự trong tương lai có thể được phát hiện và chẩn đoán nhanh hơn nhiều.

Internet mong manh – Câu chuyện về sự tập trung hóa nguy hiểm

Sự cố Cloudflare không phải là một biến cố đơn lẻ, mà là một triệu chứng của một vấn đề lớn hơn nhiều đang đe dọa internet hiện đại. Trong khi internet được thiết kế ban đầu như một mạng lưới phân tán và phi tập trung, có khả năng phục hồi cao trước các sự cố cục bộ, thì ngày nay nó đã dần trở thành một cấu trúc tập trung nguy hiểm.

Chỉ một số ít tập đoàn công nghệ lớn như Amazon (AWS), Microsoft (Azure), Google Cloud, Cloudflare, và một vài cái tên khác đang nắm giữ phần lớn hạ tầng quan trọng của internet toàn cầu. Hàng triệu website, dịch vụ trực tuyến, và ứng dụng đang cùng phụ thuộc vào những người khổng lồ này. Sự tập trung này mang lại nhiều lợi ích về mặt kinh tế và kỹ thuật – chi phí thấp hơn, hiệu suất tốt hơn, bảo mật mạnh mẽ hơn.

Nhưng nó cũng tạo ra một điểm yếu chí mạng: khi một trong những trụ cột này lung lay, cả một phần lớn internet có thể sụp đổ cùng lúc.

Khi vài công ty nắm giữ chìa khóa của internet

Sự cố Cloudflare ngày 18 tháng 11 năm 2025 không phải là sự kiện đơn lẻ, mà là một trong chuỗi các sự cố tương tự đã xảy ra trong những năm gần đây, vạch trần một thực tế đáng lo ngại: internet hiện đại đang ngày càng tập trung vào tay một số ít tập đoàn công nghệ lớn.

Chỉ trong vòng chưa đầy một tháng trước đó, vào ngày 20 tháng 10 năm 2025, Amazon Web Services (AWS) – nhà cung cấp dịch vụ đám mây lớn nhất thế giới – cũng đã gặp sự cố nghiêm trọng khiến hàng loạt dịch vụ như Snapchat, Reddit, Signal, Fortnite, Roblox và thậm chí cả sàn giao dịch tiền điện tử Coinbase ngừng hoạt động. Sự cố AWS kéo dài đến tận ngày 21 tháng 10, ảnh hưởng đến hàng tỷ người dùng trên toàn cầu.

Trước đó nữa, vào tháng 10 năm 2021, Facebook (nay là Meta) cũng từng trải qua sự cố kéo dài hơn 6 tiếng khiến Facebook, Instagram, WhatsApp và các dịch vụ liên quan hoàn toàn mất kết nối.

Những sự cố này không phải do kết nối internet của người dùng gặp vấn đề, mà do các cột trụ chống đỡ internet hiện đại gặp trục trặc. Internet ngày nay không còn là một mạng lưới phân tán và phi tập trung như thiết kế ban đầu của nó.

Thay vào đó, nó đã trở thành một hệ thống tập trung cao, trong đó khoảng 10 tập đoàn công nghệ lớn như Amazon (AWS), Microsoft (Azure), Google (Google Cloud), Cloudflare, Akamai, Fastly, và CrowdStrike đang nắm giữ phần lớn hạ tầng quan trọng. Những công ty này cung cấp dịch vụ lưu trữ đám mây, phân phối nội dung, quản lý DNS, bảo mật mạng và nhiều dịch vụ nền tảng khác mà hàng triệu website phụ thuộc vào.

Khi một trong những người khổng lồ này vấp ngã, phần lớn internet ngã theo. Đây là một mô hình nguy hiểm và mong manh hơn nhiều người tưởng tượng, nơi điểm thất bại đơn lẻ (single point of failure) không còn là một máy chủ hay một trung tâm dữ liệu, mà là cả một hệ thống, nền tảng.

Khi sự tiện lợi đánh đổi bằng khả năng phục hồi

Sự tập trung hóa này không phải không có lý do. Các công ty như Cloudflare, AWS, và Google Cloud cung cấp dịch vụ chất lượng cao với giá cả hợp lý, cơ sở hạ tầng mạnh mẽ, và các tính năng tiên tiến mà hầu hết công ty nhỏ không thể tự xây dựng được.

Đối với một startup hay một doanh nghiệp vừa và nhỏ, việc sử dụng dịch vụ của các nhà cung cấp này thường là lựa chọn hợp lý nhất về mặt kinh tế và kỹ thuật. Họ có thể tập trung nguồn lực vào phát triển sản phẩm và dịch vụ cốt lõi, thay vì phải đầu tư hàng triệu đô la vào hạ tầng mạng, đội ngũ vận hành 24/7, và các giải pháp bảo mật phức tạp.

Cloudflare, với dịch vụ miễn phí cho các website nhỏ và gói trả phí với mức giá cạnh tranh, đã trở thành lựa chọn mặc định của hàng triệu website trên toàn thế giới.

Tuy nhiên, sự tiện lợi và hiệu quả kinh tế này đi kèm với một cái giá lớn: mất đi khả năng phục hồi (resilience) của internet như một tổng thể. Trong quá khứ, khi internet còn phân tán hơn, sự cố ở một nơi hiếm khi ảnh hưởng đến toàn bộ mạng lưới. Nếu một máy chủ hay một nhà cung cấp dịch vụ gặp vấn đề, người dùng có thể chuyển sang các lựa chọn thay thế khác.

Nhưng ngày nay, khi 20% website toàn cầu cùng phụ thuộc vào Cloudflare, một sự cố duy nhất có thể khiến tất cả chúng đồng loạt ngừng hoạt động. Không có phương án dự phòng nào có thể hoạt động khi chính cổng vào đã bị đóng lại. Đây là một bài học đắt giá về việc đặt quá nhiều trứng vào một giỏ, và đặt ra câu hỏi liệu ngành công nghiệp có cần suy nghĩ lại về cách xây dựng hạ tầng internet hay không.

Tương lai nào cho một internet bền vững hơn?

Câu hỏi đặt ra là liệu chúng ta có thể làm gì để giảm thiểu rủi ro này. Một số chuyên gia đề xuất các công ty nên áp dụng chiến lược đa nhà cung cấp (multi cloud), sử dụng dịch vụ của nhiều nhà cung cấp khác nhau để phân tán rủi ro. Ví dụ, một website có thể sử dụng Cloudflare làm CDN chính nhưng có Fastly hoặc Akamai làm dự phòng, sẵn sàng chuyển đổi khi cần thiết.

Tuy nhiên, giải pháp này đòi hỏi đầu tư lớn về thời gian, tiền bạc và công sức kỹ thuật, khiến nó không khả thi đối với phần lớn doanh nghiệp nhỏ và vừa. Hơn nữa, việc duy trì nhiều hệ thống song song cũng tạo ra độ phức tạp riêng và có thể dẫn đến các lỗi mới.

Một hướng đi khác là chính các nhà cung cấp dịch vụ lớn cần đầu tư nhiều hơn vào việc xây dựng hệ thống có khả năng chịu lỗi cao hơn, với nhiều lớp bảo vệ và cơ chế tự động phục hồi tốt hơn. Sự cố lần này cho thấy ngay cả một công ty lớn và có kinh nghiệm như Cloudflare cũng có thể mắc những sai lầm cơ bản trong thiết kế hệ thống.

Việc áp dụng các phương pháp kiểm thử nghiêm ngặt hơn, đặc biệt là chaos engineering (kỹ thuật cố tình tạo ra lỗi để kiểm tra khả năng phục hồi của hệ thống), có thể giúp phát hiện và khắc phục những điểm yếu trước khi chúng gây ra sự cố thực sự.

Cuối cùng, cộng đồng công nghệ cần có những cuộc thảo luận nghiêm túc về việc có nên có các quy định và tiêu chuẩn bắt buộc đối với các công ty nắm giữ hạ tầng quan trọng của internet, đảm bảo họ duy trì mức độ dự phòng và khả năng phục hồi tối thiểu.

Internet đã trở thành một phần không thể thiếu của đời sống hiện đại, và chúng ta không thể để nó phụ thuộc hoàn toàn vào may rủi hay thiện chí của một số ít công ty tư nhân.

Lời kết – Một lời nhắc nhở đắt giá

Sự cố Cloudflare ngày 18 tháng 11 năm 2025 đã qua đi, các dịch vụ đã được khôi phục, và internet tiếp tục quay trở lại nhịp độ vận hành thường ngày. Nhưng những bài học để lại vẫn còn đó, sâu sắc và đáng suy ngẫm. Đây không chỉ là câu chuyện về một lỗi kỹ thuật hay một quy trình vận hành thiếu sót, mà là một lời nhắc nhở mạnh mẽ về sự mong manh của internet hiện đại và trách nhiệm nặng nề của những ai đang nắm giữ các cột trụ của nó.

Như CEO của Cloudflare là Matthew Prince đã thừa nhận trong thông báo chính thức: Một sự cố như hôm nay là không thể chấp nhận được. Chúng tôi đã thiết kế hệ thống của mình để có khả năng phục hồi cao trước các sự cố nhằm đảm bảo lưu lượng luôn tiếp tục lưu thông. Khi gặp sự cố trong quá khứ, điều đó luôn dẫn chúng tôi đến việc xây dựng các hệ thống mới, có khả năng phục hồi tốt hơn. (An outage like today is unacceptable. We’ve architected our systems to be highly resilient to failure to ensure traffic will always continue to flow. When we’ve had outages in the past it’s always led to us building new, more resilient systems.)

Đối với hàng triệu người dùng trên toàn thế giới, 3 giờ không thể truy cập các dịch vụ quen thuộc có lẽ chỉ là một sự bất tiện tạm thời. Nhưng đối với các doanh nghiệp thương mại điện tử, mỗi phút ngừng hoạt động đồng nghĩa với hàng tỷ doanh thu bị mất. Đối với các dịch vụ y tế, giáo dục hay tài chính trực tuyến, sự gián đoạn có thể gây ra hậu quả nghiêm trọng hơn nhiều. Và đối với chính Cloudflare, đây là một vết nhơ lớn trên danh tiếng cũng như một bài học xương máu về tầm quan trọng của việc kiểm soát chất lượng, thiết kế hệ thống có khả năng chịu lỗi, và không bao giờ được chủ quan với những thay đổi dù nhỏ nhất.

Sự cố này cũng nhắc nhở tất cả chúng ta – từ người dùng thông thường đến các tổ chức lớn – rằng internet mà chúng ta đang sử dụng mỗi ngày không phải là một thứ gì đó tự nhiên và bất biến, mà là kết quả của vô số hệ thống phức tạp do con người xây dựng và vận hành, với tất cả những điểm yếu và khả năng mắc lỗi vốn có của con người.

Trong những ngày và tuần tới, Cloudflare sẽ tiếp tục công bố các báo cáo chi tiết hơn về sự cố, triển khai các biện pháp khắc phục đã cam kết, và hy vọng lấy lại được niềm tin từ khách hàng và cộng đồng. Nhưng cho dù họ có làm tốt đến đâu, sự cố ngày 18 tháng 11 năm 2025 sẽ mãi được ghi nhớ như một trong những ngày tồi tệ nhất của internet hiện đại – ngày mà 20% thế giới trực tuyến đồng loạt đứng im, và tất cả chúng ta nhận ra rằng nền móng mà chúng ta đang đứng trên thực ra mong manh hơn nhiều so với những gì chúng ta từng nghĩ.

Hy vọng rằng từ tro tàn của sự cố này, một internet mạnh mẽ hơn, an toàn hơn và phục hồi nhanh hơn sẽ được xây dựng – một internet xứng đáng với vai trò trung tâm mà nó đang đóng trong cuộc sống của hàng tỷ người trên toàn thế giới.

cloudflare (1)

ha-tang-mang (1)

internet (1)

su-co-cloudflare (1)

sap-mang (1)

su-co-mang (1)

clickhouse (1)

cdn (1)

workers-kv (1)

turnstile (1)